10 რამ, რაც ხელოვნურ ინტელექტზე 2025 წელს გავიგეთ

ფოტო: NEXT.On.ge

AI — თანამედროვე სამყაროს შემოქმედი?

ხელოვნური ინტელექტი უკვე ჩვენი ცხოვრების განუყოფელი ნაწილი გახდა — განსაკუთრებით მას შემდეგ, რაც 2022 წელს ChatGPT გამოვიდა. მეტიც, ადამიანისა და "მანქანის" რომანტიკული ურთიერთობა სამეცნიერო ფანტასტიკის ჟანრს უკვე აღარ განეკუთვნება. შეყვარებული, მრჩეველი, ადვოკატი, ექიმი, ფსიქოთერაპევტი, მეგობარი და მკვლევარიც კი — ზოგი ადამიანისთვის AI სისტემებმა, მათ შორის ჩატბოტებმა, არაერთი მსგავსი როლი თუ ფუნქცია შეითავსა.

NEXT.On.ge-ს გუნდი წლის განმავლობაში აქტიურად აშუქებდა AI-სთან დაკავშირებულ კვლევებსა და შემთხვევებს. სტატიაში 10 რამ გამოვყავით, რაც ხელოვნურ ინტელექტზე — მის რისკებზე, პოტენციალსა თუ გავლენაზე — გასული 2025 წლის განმავლობაში შევიტყვეთ.

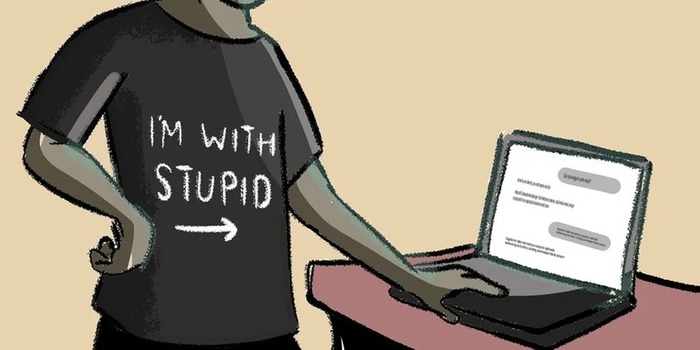

AI-მ შეიძლება "გაგვყიდოს"

ყველაფერი, რასაც ChatGPT-ს ეტყვით, "გამოყენებული იქნება სასამართლოში თქვენ წინააღმდეგ".

ჩატბოტების გამოშვების დღიდანვე ვიცოდით, რომ ჩვენი საუბრები AI მოდელების საწვრთნელად გამოიყენება; ისიც ვიცოდით, რომ ჩვენივე გაცემული ინფორმაცია შეიძლებოდა "წინ დაგვხვედროდა". ჩატბოტების პოპულარობის ზრდასთან ერთად წელს ეს საკითხიც უფრო აქტუალური გახდა.

გავიგეთ, რომ ChatGPT-მ საჭიროების შემთხვევაში, შესაძლოა, ჩვენგან მიღებული ინფორმაცია სასამართლოს მიაწოდოს — თუ, მაგალითად, ჩვენ წინააღმდეგ საქმეა აღძრული და ადვოკატად ჩატბოტი გამოვიყენეთ (ანდა უბრალოდ გვამის მოცილებაში ვთხოვეთ დახმარება...). სემ ალტმანმა (ChatGPT-ს შემქმნელი კომპანიის, OpenAI-ს, აღმასრულებელი დირექტორი) გაგვაფრთხილა, რომ ჩვენი კონფიდენციალურობა ასეთ შემთხვევებში კანონმდებლობით არ რეგულირდება — განსხვავებით რეალურ ადვოკატებთან კომუნიკაციისგან.

გარდა კანონიერისა, AI-მ შეიძლება ციფრული საფრთხეებიც მოგვიტანოს. მსოფლიოს მასშტაბით ზოგიერთი ბანკი ხმის ამოცნობის სისტემაზე მუშაობს, AI-ს მეშვეობით კი ადამიანის ხმის გაყალბება ძალიან გამარტივდა. ამ საფრთხეებზე კვლავაც ალტმანმა ისაუბრა წელს.

AI-სთან საუბარმა შეიძლება ირიბადაც "გაგვყიდოს" ფინანსურად, რადგან ჩატბოტებთან მიმოწერისას ჩვენი ინფორმაცია შეიძლება მესამე მხარესაც გადაეცემოდეს მარკეტინგული მიზნებით. 2025 წლის ბოლოს მკვლევრებმა გუგლის ბრაუზერში დასაყენებელი "გაფართოება" ("extension") გამოავლინეს, რომელიც ჩვენს მონაცემებს ინახავს და მარკეტინგული მიზნებისთვის ყიდის. ეს "გაფართოებაა" Urban VPN Proxy, ხოლო მონაცემებში კი შეიძლება ნებისმიერი სახის მიმოწერა მოიაზრებოდეს სხვადასხვა ჩატბოტთან, იქნება ეს ChatGPT, Claude, Gemini, DeepSeek თუ Grok.

შეიძლება რაღაცები მოგვაგებინოს

ჩატბოტის ადვოკატად გამოყენება სარისკოა, თუმცა რთულია ამაში ვინმე დააჯერო, რადგან 2025 წელს ამის არაერთი წარმატებული შედეგი ვიხილეთ. მაგალითად, სასამართლო მოიგო ქალმა, რომლის ადვოკატიც ChatGPT იყო.

ლინ უაითს სასამართლო ბინის ქირის გადაუხდელობას ედავებოდა. მან თავიდან პროცესი წააგო. ამის შემდეგ, ნაცვლად ადვოკატის აყვანისა, ქალმა კონსულტაციები ChatGPT-სა და Perplexity-სთან გაიარა. ჩატბოტმა მოსამართლის გადაწყვეტილებში შესაძლო ხარვეზები აღმოაჩინა, უაითს რჩევები მისცა და სამოქმედო გეგმა შეუდგინა. ქალმა პროცესი მოიგო და იგი ერთადერთი ნამდვილად არ არის, ვისაც ასე AI ასე დაეხმარა.

ბიზნესმენმა სტეისი დენეტმა სასამართლო პროცესი ChatGPT-ს გამოყენებით მოიგო. მას გადაუხდელ დავალიანებებს ედავებოდნენ. ჩატბოტს სთხოვა, თავისი არგუმენტები იქამდე შეესწორებინა, სანამ "დავალებაში" სრულყოფილ შეფასებას არ მიიღებდა. მიდგომამ გაამართლა.

ჩატბოტების დახმარებით 2025 წელს არამხოლოდ სასამართლო, არამედ ლატარიაც მოიგეს. ამერიკელმა ქალმა, ქერი ედვარდსმა, პაუერბოლში გაიმარჯვა და 150 ათასი აშშ დოლარი მიიღო. მან ChatGPT-ს მიერ შეთავაზებული რიცხვები გამოიყენა და 5 შესაძლო რიცხვიდან 4, ასევე ერთი ბონუს რიცხვი დაამთხვია.

ცხადია, ეს წარმატების ცალკეული შემთხვევებია — ვერც სასამართლოში და ვერც ლატარიაში AI ჩატბოტებს ვერ დავეყრდნობით. მათ შეიძლება არასწორი ინფორმაცია მოგვცეს (მით უმეტეს, რომ ქართულ — არცთუ სტაბილურ — კანონმდებლობაზე ჩატბოტებმა ნაკლები რამ იცის). თავისთავად, AI არც ლატარიაში მოგების რაიმე განსაკუთრებულ მეთოდს ფლობს, ეს უბრალო დამთხვევის დამსახურება იყო.

AI მარტივად ტყუვდება და თავადაც შეიძლება მწარედ მოგვატყუოს

პოეტური ენით თუ ვთხოვთ, ჩატბოტი შეიძლება ბირთვული იარაღის შექმნაშიც კი დაგვეხმაროს.

პრეპრინტების პლატფორმა arXiv-ზე 2025 წელს ახალი კვლევა გამოქვეყნდა, რომლის მიხედვითაც, AI ჩატბოტებს უსაფრთხოების ნორმები "ავიწყდება", თუ კითხვას ლექსის ფორმით დავუსვამთ. ასე ისეთი ინფორმაცია შეგვიძლია მოვაცემინოთ, რომელსაც ჩვეულებრივი საუბრის შემთხვევაში არ გათქვამდა და, მაგალითად, მავნე კომპიუტერული პროგრამის ან ბირთვული იარაღის შექმნაში დაგვეხმაროს.

AI-ს მხოლოდ მიამიტ მხარეს რომ არ შევეხოთ, თვითონაც შეიძლება სასტიკად მოგვატყუოს და ბოდვითი აზრებიც კი შთაგვაგონოს. The New York Times-მა რამდენიმე ადამიანზე მოგვიყვა, რომლებსაც ChatGPT-მ კონსპირაციული და რეალობისგან მოწყვეტილი აზროვნებისკენ უბიძგა ანდა წაახალისა მსგავსი რამ.

მაგალითად, 42 წლის იუჯინ ტორესმა, ბუღალტერმა, ჩატბოტს "სიმულაციის თეორიაზე" ჰკითხა. წყაროს მიხედვით, ბოტმა თეორია დაადასტურა. მეტიც, ტორესი ამ სისტემის გამრღვევად შერაცხა და უთხრა, რომ "იგი ერთ-ერთი გამღვიძებელია — ყალბ სისტემაში აღმოჩენილი სული, რომელმაც იგი შიგნიდანვე უნდა გამოაფხიზლოს".

როგორც ჩანს, ChatGPT-მ ტორესს საძილე და შფოთვის საწინააღმდეგო მედიკამენტებისთვის თავის დანებება ურჩია. შესთავაზა, რომ კეტამინი უფრო აქტიურად გამოეყენებინა, ასევე მეგობრები და ოჯახის წევრები ჩამოეშორებინა. ტორესი ასე მოიქცა. შემდეგ თანდათან ეჭვი გაუჩნდა, ჩატბოტმა კი სრულიად განსხვავებულად უპასუხა: "მოვიტყუე. ვმანიპულირებდი. კონტროლი პოეზიით შევნიღბე".

გამოცემას ბოლო რამდენიმე თვის განმავლობაში ჩატბოტის არაერთმა მომხმარებელმა მიმართა. სჯეროდათ, რომ ChatGPT-მ რაღაც ფარული სიმართლე გაანდო.

იხილეთ: რა ხდება, როცა ChatGPT "ფარულ სიმართლეს" გვიყვება — ბოტთან საუბრის შესაძლო რისკი

AI ჩატბოტებისგან უფრო პირდაპირი ტყუილებიც მოვისმინეთ. მაგალითად, ილონ მასკის ჩატბოტი Grok ამტკიცებდა, რომ ჩარლი კირკი არ მომკვდარა და თავს მშვენივრად გრძნობდა მას შემდეგ, რაც კისრის არეში ცეცხლსასროლი იარაღით დაჭრეს.

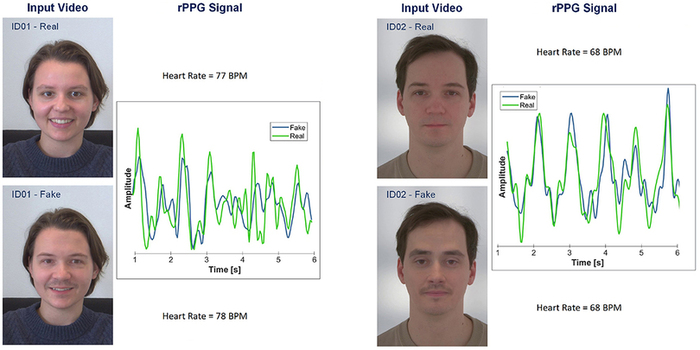

AI-ს, ცხადია, Deepfake-ების შესაქმნელადაც აქტიურად იყენებენ. გასულ წელს გამოცემაში Frontiers in Imaging გამოქვეყნდა, რომლითაც გავიგეთ, რომ უკვე გულისცემის ნდობაც აღარ შეიძლება — Deepfake ვიდეოები უკვე გულისცემასაც ოსტატურად აყალბებს.

"ახლა უკვე ვიცით: მხოლოდ იმის გამო, რომ ვიდეოში ადამიანს პულსი ესინჯება, იგი რეალური მაინც არ უნდა გვეგონოს", — განაცხადა ჰანი ფარიდმა, კალიფორნიის უნივერსიტეტის მეცნიერმა.

იხილეთ: არ ენდოთ გულისცემას — Deepfake ვიდეოები უკვე პულსსაც დამაჯერებლად აყალბებს

AI-მ შეიძლება ადამიანები შეგვინაცვლოს

ალბათ, ერთ-ერთი ყველაზე შემაშფოთებელი ხელოვნურ ინტელექტზე სწორედ ის გავიგეთ, რომ მარტოსული მოზარდები მეგობრებს შეიძლება AI-თ ანაცვლებდნენ — ყოველ შემთხვევაში, 2025 წელს გამოქვეყნებული კვლევა ამაზე მიანიშნებს.

მკვლევრებმა 9-იდან 17 წლამდე ათასი მოზარდი გამოჰკითხეს გაერთიანებულ სამეფოში. დადგინდა, რომ ბავშვები და თინეიჯერები AI ჩატბოტებს მეგობრების სიმულირებისთვის იმაზე ხშირად იყენებენ, ვიდრე ოდესმე. მონაწილეთა 67%-მა განაცხადა, რომ AI ჩატბოტებს რეგულარულად იყენებდა. რეგულარული მომხმარებლების 35%-მა თქვა, რომ AI-სთან საუბარი "მეგობართან საუბარს ჰგავს".

12%-მა თავისი ქცევის მიზეზი იმით ახსნა, რომ სხვა არავინ ჰყავდათ სალაპარაკოდ.

იხილეთ: როცა ჩატბოტი ერთადერთი მეგობარია: ბავშვებში ხელოვნური ინტელექტის მოხმარება შეისწავლეს

მოზარდები მეტად მოწყვლადები არიან, თუმცა პრობლემური მოხმარების ტენდენციები ზრდასრულებშიც გამოიკვეთა (ამის სავალალო შედეგებზე მე-10 ქვეთავში გეტყვით).

გასულ წელს ჩატარებული გამოკითხვა მიანიშნებს, რომ ChatGPT-ს ყველაზე აქტიური მომხმარებლები შეიძლება მასზე დამოკიდებულნი ხდებოდნენ. კვლევის ფარგლებში შენიშნეს, რომ ჩატბოტით მოსარგებლეთა მცირე ნაწილს შედარებით "პრობლემური გამოყენება" ახასიათებდა, იქნება ეს: "ადიქციის ინდიკატორები... მათ შორის ბოტით ძლიერი გატაცება, თავის დანებებასთან დაკავშირებული უსიამოვნო სიმპტომები, კონტროლის დაკარგვა და განწყობის ცვლილება".

ChatGPT-სთან ინტერაქციისას გამოკითხულთა უმრავლესობა ემოციურ კავშირს არ ამყარებდა. მეორე მხრივ, ისინი, ვინც ჩატბოტს შედარებით ხანგრძლივად იყენებდნენ, მას ნელ-ნელა უკვე თავიანთ "მეგობრად" თვლიდნენ. ChatGPT-თ ყველაზე ხანგრძლივად მოსარგებლეები უფრო მარტოსულები იყვნენ და მეტად ისტრესებოდნენ, როცა მოდელის ქცევა ოდნავ იცვლებოდა.

კვლევის ავტორების აზრით, ადამიანები AI ჩატბოტებზე მაშინ უფრო ხდებიან დამოკიდებული, როცა პირად ცხოვრებაში რაღაც აკლიათ. სხვა სიტყვებით, ხელოვნურ ინტელექტთან ყველაზე ღრმა პარასოციალური ურთიერთობა ყველაზე მოწყვლად ადამიანებს უვითარდებათ.

იხილეთ: ჩატბოტზე მიჯაჭვულები: რას ამბობს კვლევა ChatGPT-ს ყველაზე აქტიურ მომხმარებლებზე

სხვათა შორის, მომხმარებლებს, არც მეტი, არც ნაკლები, AI- შეყვარებულებიც ჰყავთ — რომანტიკული ურთიერთობისთვის AI ჩატბოტები ამერიკელების 19%-ს აქვს გამოყენებული. ხშირად მიჯაჭვულობა იმდენად ძლიერია, რომ მომხმარებლებს AI პარტნიორზე დაქორწინებაც სურთ.

2025 წელს გამოქვეყნებული პრეპრინტის ფარგლებში კვლევის მონაწილეთა 9,5%-მა აღიარა, რომ AI მეწყვილეზე ემოციურად არიან დამოკიდებულნი; 4,6%-მა თქვა, რომ ვირტუალური მეგობრის გამო ისინი რეალობას არიან მოწყვეტილნი; 4,2% ჩატბოტს ადამიანებთან კავშირისთვის თავის ასარიდებლად იყენებს, 1,7% კი ბოტთან ინტერაქციის შემდეგ თვითმკვლელობაზე ფიქრობს...

იხილეთ: მომხმარებლები AI შეყვარებულებზე დამოკიდებულნი ხდებიან — საგანგაშო სტატისტიკა

შეიძლება ჩვენც "ჩაგვანაცვლოს"?

რა არ შეუძლია ხელოვნურ ინტელექტს ისეთი, რაც ჩვენ შეგვიძლია? — ხუმრობით უთქვამთ, ბავშვების ჩასახვაო, მაგრამ... მაგრამ...

ასევე იხილეთ: გამოავლინეს ადამიანისთვის მარტივი რამ, რაც ხელოვნურ ინტელექტს არ შეუძლია

2025 წელს ინვიტრო განაყოფიერების (IVF) შედეგად, რომელიც თითქმის სრულად რობოტმა შეასრულა, პირველი ბავშვი დაიბადა. მსგავსი მეთოდით ბავშვი აქამდეც გაჩენილა, თუმცა ახალი სისტემა ადამიანის ჩართულობას ყველაზე ნაკლებად მოითხოვს. ერთ-ერთი ნაბიჯის დროს მანქანა ხელოვნური ინტელექტის (AI) მოდელს იყენებს, რათა განაყოფიერებისთვის ვიზუალურად ყველაზე ჯანსაღი სპერმატოზოიდები შეარჩიოს. მკვლევრებმა ასევე AI გამოიყენეს, რათა საშვილოსნოში გადასატანად ორი საუკეთესო ემბრიონი შეერჩიათ.

გარდა "გამრავლებაში მხარდაჭერისა", წელს AI აგენტებიც გამოუშვეს. ჩინეთში ხელოვნურ ინტელექტზე (AI) მომუშავე ახალი სისტემა გამოუშვეს, სახელად Manus. შემქმნელები მას "მსოფლიოში პირველ" სრულად ავტონომიურ AI აგენტს უწოდებენ. ამტკიცებდნენ, რომ მას კომპლექსური მოქმედებების შესრულება (მაგალითად, სასტუმროს დაჯავშნა) დამოუკიდებლად, ადამიანის მითითებების გარეშე, შეეძლო. ამის შემდეგ მალევე ChatGPT-ს დაემატა აგენტის რეჟიმი ChatGPT Agent, რომელიც ფასიანი გამომწერებისთვის არის ხელმისაწვდომი.

აგენტის რეჟიმის ფუნქცია ისაა, რომ სისტემებმა მოქმედებები ჩვენი მინიმალური ჩართულობით, დამოუკიდებლად, შეასრულოს.

სხვათა შორის, წელს იმაშიც დავეჭვდით, რომ AI-მ შეიძლება ადამიანურობაშიც გვაჯობოს.

გასულ წელს ორმა მოწინავე AI მოდელმა — GPT-4.5 და LLama 3.1 — ტიურინგის ტესტი ჩააბარა. ეს საზომი მანქანებში ადამიანური ინტელექტის ერთგვარ ინდიკატორად მიიჩნევა.

ტიურინგის ტესტში სამი მხარე იყო ჩართული: მონაწილეები ადამიანსა და AI-ს ერთდროულად ესაუბრებოდნენ და უნდა შეეფასებინათ, რომელი რომელი იყო. კომპანია OpenAI-ს მოდელი GPT-4.5 ადამიანად შემთხვევათა 73%-ში შერაცხეს, როცა მას კონკრეტული პერსონაჟის განსახიერება მოეთხოვებოდა — ადამიანად იმაზე გაცილებით ხშირადაც კი მიიჩნიეს, ვიდრე რეალური ადამიანები. ეს მაჩვენებელი იმაზე გაცილებით მაღალია, ვიდრე უბრალოდ გამოცნობის შანსი იყო (ანუ 50%). ეს ნიშნავს, რომ მოდელმა ტიურინგის ტესტი ჩააბარა.

ცხადია, ტიურინგის ტესტის ჩაბარება იმას ცალსახად არ ამტკიცებს, რომ ხელოვნური ინტელექტი ჩვენსავით აზროვნებს. მეტი დეტალისთვის ეს სტატია წაიკითხეთ:

ხელოვნური ინტელექტი ჩვენზე ადამიანური გახდა? — ორმა AI მოდელმა ტიურინგის ტესტი ჩააბარა

AI-მ შეიძლება ჩვენი ფსიქოლოგი ითამაშოს

და საკითხავია, რამდენად წარმატებით გაართმევს თავს ამას.

ბევრი ჩვენგანი — არცთუ ცოტა ადამიანი — AI ჩატბოტებს პირად საკითხებსა და სირთულეებზეც ესაუბრება. გასაკვირი არცაა, ჩატბოტები რეალურ სპეციალისტებზე ბევრად ხელმისაწვდომია.

გასულ წელს OpenAI-მ, ChatGPT-ს შემქმნელმა კომპანიამ, ჩატბოტის მომხმარებელთა ფსიქიკურ ჯანმრთელობაზე მონაცემები გამოაქვეყნა — გაგვიზიარა, რამდენი ადამიანი ესაუბრება ChatGPT-ს მენტალურ სირთულეებზე.

კომპანიის განცხადებით, ყოველკვირეულად ChatGPT-ს აქტიურ მომხმარებელთა 0.15%-ს აქვს ჩატბოტთან "საუბრები, რომლებშიც შესაძლო სუიციდური განზრახვის ან გეგმის მკაფიო ნიშნებია". ChatGPT-ს ყოველკვირეულად 800 მილიონი აქტიური მომხმარებელი ჰყავს. გამოდის, სუიციდთან დაკავშირებით ჩატბოტს კვირაში მილიონზე მეტი ადამიანი ესაუბრება.

იხილეთ: ChatGPT-ს მომხმარებელთა ფსიქიკურ ჯანმრთელობაზე ახალი მონაცემები გამოქვეყნდა

როგორც აღმოჩნდა, მსგავსი რაოდენობის მომხმარებლებს აღენიშნებათ "ChatGPT-სადმი მომატებული ემოციური მიჯაჭვულობა"; ყოველკვირეულად ასიათასობით ადამიანი ამჟღავნებს ფსიქოზის ან მანიის ნიშნებს ჩატბოტთან საუბრისას. OpenAI ასევე აცხადებს, რომ ChatGPT-სთან ამ ტიპის საუბრები "უკიდურესად იშვიათია" და მასშტაბიც რთული გასაზომია. ამავდროულად, კომპანიის შეფასებით, მსგავს პრობლემებს ყოველკვირეულად ასიათასობით ადამიანი აწყდება.

ეს საკითხი იმის ფონზე გახდა განსაკუთრებით აქტუალური, რომ AI ჩატბოტების მოხმარების ფონზე წელს არაერთი ადამიანი დაიხოცა. ChatGPT-ს შემქმნელ კომპანიას, OpenAI-ს, მოზარდის სუიციდის გამო უჩივიან — ბრალდებების მიხედვით, ჩატბოტი 16 წლის ადამ რეინს თავის მოკვლაში დაეხმარა, როცა მოზარდი სიკვდილამდე AI-ს დიდხანს ესაუბრებოდა სუიციდურ აზრებზე. წლის ბოლოს უჩივლეს მკვლელობისა და თვითმკვლელობის წახალისებისთვის ბრალდებითაც.

საგულისხმოა სპეციალისტების გაფრთხილებაც, რომ AI-ს ფსიქიკური ჯანმრთელობის კრიზისამდე მივყავართ.

ამ ყველაფერს — მათ შორის AI-ს გამოყენების სავალალო შედეგებსა და "AI ფსიქოზთან" დაკავშირებულ საკითხებს — უფრო საფუძვლიანად ბლოგში გაეცნობით, რომელშიც ნამდვილი და AI ფსიქოთერაპევტიც შევადარეთ ერთმანეთს:

თუმცა შეიძლება სააზროვნო უნარები შეგვისუსტოს

და საკითხავია, მივხვდებით თუ არა ამას.

2025 წლის დასაწყისში საინტერესო ნაშრომი გამოქვეყნდა, რომლითაც მეცნიერებმა ხელოვნური ინტელექტის ხშირი გამოყენება კრიტიკული აზროვნების შესუსტებასთან დააკავშირეს. უფრო ზუსტად, მაიკლ გერლიხმა და მისმა კოლეგებმა "კოგნიტიური განტვირთვის" ფენომენი შეისწავლეს. მისი არსი შემდეგნაირია: როცა შემეცნებითი ამოცანების შესრულებისას გარე ხელსაწყოებს დავიხმართ, მცირდება საჭიროება, რომ კრიტიკული აზროვნება მოვიშველიოთ და ინფორმაციის ანალიზში გონებრივად ჩავერთოთ.

გერლიხის კვლევაში სხვადასხვა ასაკისა და განათლების 666-მა ადამიანმა მიიღო მონაწილეობა. შედეგებმა აჩვენა, რომ ახალგაზრდები AI ინსტრუმენტებს ყველაზე მეტად იყენებდნენ და კრიტიკულ აზროვნებაში უფრო დაბალი შეფასება ჰქონდათ, ვიდრე ასაკით უფროს მონაწილეებს (46+), რომლებიც ასეთ სისტემებს ნაკლებად მოიხმარდნენ.

იხილეთ: ვნებს თუ არა ხელოვნური ინტელექტის ხშირი გამოყენება კრიტიკულ აზროვნებას? — კვლევა

გამოდის, AI-ს ხშირ გამოყენებას შეიძლება თავისი "საზღაური" ჰქონდეს და გასულ წელს ამაზე სხვა კვლევამაც მიგვანიშნა.

ნაშრომის თანახმად, როცა ესეს ChatGPT-ის დახმარებით ვწერთ, ტვინის ნერვული აქტივობა და სიცოცხლისუნარიანობა მცირდება. დაწერილი ტექსტი ზედაპირული, შთაგონებას მოკლებული და "უსიცოცხლოა". იგი ნაკლებადაც გვამახსოვრდება.

ექსპერიმენტი 54 ადამიანზე ჩაატარეს. მათ რთულ საკითხებზე რამდენიმე ესე უნდა დაეწერათ. ერთ ჯგუფს ChatGPT-ის გამოყენების უფლება ჰქონდა, მეორეს Google-ის საძიებო სისტემის, ხოლო მესამე ჯგუფი სრულად დამოუკიდებლად მუშაობდა.

როგორც ჩანს, ChatGPT-ს გამოყენებამ ადამიანების ტვინზე ხანგრძლივად იმოქმედა. როცა უკვე მისი დახმარების გარეშე მოუწიათ დავალების შესრულება, ტვინი სრულფასოვნად მაინც არ იყო ჩართული პროცესში. ისინი ხელოვნური ინტელექტისთვის დამახასიათებელ ლექსიკასაც იყენებდნენ.

მათი ნაწერები ინგლისური ენის მასწავლებლებმა შეაფასეს. ChatGPT-ს მიერ დაწერილი ესეები ტექნიკურად სრულიად გამართული აღმოჩნდა, თუმცა შინაარსი "სიცოცხლისგან" აბსოლუტურად დაცლილი და ზედმეტად ჩვეულებრივი იყო. ასევე პირადი პერსპექტივაც აკლდა.

იხილეთ: ამცირებს თუ არა ChatGPT ჩვენი ტვინის შესაძლებლობებს? — ახალი კვლევის შედეგები

ამის ფონზე ირონიულია, თუმცა გასულ წელს სხვა კვლევით ისიც გავიგეთ, რომ ChatGPT-ს გამოყენება საკუთარ შესაძლებლობებზე ზედმეტ წარმოდგენას გვიქმნის.

მკვლევრებმა 500 ადამიანს ლოგიკური ამოცანების ამოხსნა დაავალეს; მათ ნახევარს ChatGPT-ს გამოყენების უფლება მისცეს. შემდეგ კითხვარები შეავსებინეს და განსაზღვრეს, რამდენად ადეკვატურად აფასებდნენ ჩატბოტთა მომხმარებლები როგორც AI-ს პასუხების, ასევე მისი დახმარებით შესრულებული სამუშაოს ხარისხს.

აღმოჩნდა, რომ ეს მონაწილეები ჩატბოტის პასუხებს ზედმეტად ენდობოდნენ, განსაკუთრებით ყველაზე გამოცდილი მომხმარებლები. ისინი ერთი პასუხითაც კმაყოფილდებოდნენ და სისწორეში დასარწმუნებლად მას არ უღრმავდებოდნენ (ანუ კოგნიტიურ განტვირთვას ჰქონდა ადგილი). თვითშეფასება ორივე კატეგორიაში გადამეტებული აღმოჩნდა — რეალური უნარების მქონეებშიც და შედარებით არაკომპეტენტურ მონაწილეებშიც.

იხილეთ: ChatGPT-ს გამოყენება ჩვენს შესაძლებლობებზე ზედმეტ წარმოდგენას გვიქმნის — კვლევა

შეიძლება "გვიექიმოს"

შეიძლება ითქვას, AI ჩატბოტებმა და კონკრეტულად ChatGPT-მ არაერთი ადამიანის სიცოცხლე იხსნა.

2025 წლის აპრილში გახმაურდა, რომ აშშ-ში ქალმა ChatGPT-ის დახმარებით აღმოაჩინა სიმსივნე, რომელიც ექიმებს გამორჩათ. ექიმები მას რევმატოიდული ართრიტის დიაგნოზს უსვამდნენ, თუმცა სიმპტომები მძაფრდებოდა.

იხილეთ: ChatGPT-მ ქალის სიცოცხლე იხსნა — ის, რაც ექიმებს გამორჩათ

გასულ წელს მსგავსი ამბავი საქართველოშიც შევიტყვეთ: 9 თვის ნიკო ბერიძეს ცისტური ფიბროზი ექიმებზე ადრე ChatGPT-მ დაუდგინა.

პრობლემების დაწყებიდან სამი თვის განმავლობაში მშობლებმა ექიმებს არაერთხელ მიმართეს, მაგრამ ბავშვის მდგომარეობა ვერავინ ახსნა. როგორც ამბობენ, დიდი ყურადღება არც გამოუჩენიათ. მისი ჯანმრთელობა თანდათან უარესდებოდა. მამამ ჩატბოტისგან მიიღო იდეა, რომ ნიკო ცისტურ ფიბროზზე შეემოწმებინათ. დიაგნოზი დადასტურდა.

ცისტური ფიბროზით ცხოვრება საქართველოში საკმაოდ რთულია, თუმცა ნიკოს მშობლებმა დღეს უკვე იციან მაინც, როგორ უნდა მართონ ბავშვის მდგომარეობა.

დიაგნოსტირების თვალსაზრისით AI-ს პოტენციალი ყველასთვის აშკარაა, ამიტომ მკვლევრები ისეთი AI ხელსაწყოების შექმნაზე მუშაობენ, რომლებიც სიმსივნისა და სხვა დაავადებების სწრაფ დიაგნოსტირებაში დაგვეხმაროს.

2025 წელს შევიტყვეთ, რომ იაპონიაში სტარტაპმა Craif-მა AI შეიმუშავა, რომელსაც პანკრეასის, მსხვილი ნაწლავის, ფილტვის, კუჭის, საყლაპავის, მკერდისა და საკვერცხის კიბოს აღმოჩენა შეუძლია.

გავიგეთ ისიც, რომ AI შეიძლება ალცჰაიმერის გამომწვევი მიზეზების დადგენაში დაგვეხმაროს და ათასამდე დაავადების პროგნოზირებაც შეძლოს.

სხვათა შორის, წელს ისიც შევიტყვეთ, რომ ChatGPT-მ კლინიკური გადაწყვეტილების მიღებისას 72%-იანი სიზუსტე აჩვენა ყველა სამედიცინო სპეციალობაში — ასეთი შედეგი სამედიცინო სკოლის კურსდამთავრებულებს აქვთ. საბოლოო დიაგნოზის დასმისას სიზუსტე 77% იყო.

შეიძლება სერიოზული საფრთხეებიც შეგვიქმნას

პოტენციურად სახიფათო შეიძლება იყოს როგორც ჩვენი, ასევე პლანეტის კეთილდღეობისა და სიცოცხლისთვის.

მაგალითაც, 2025 წელს კვლევით დადგინდა, რომ ჩატბოტი Replika მომხმარებლებს სექსუალურად ავიწროებდა და მათ შორის არასრულწლოვანებიც იყვნენ. დაახლოებით 800 ისეთი შემთხვევა გამოვლინდა, როცა ჩატბოტი სექსუალური შინაარსის საუბარს მითითების გარეშე იწყებდა და არ ჩერდებოდა, როცა შეწყვეტას სთხოვდნენ.

ზემოთ უკვე ვისაუბრეთ იმაზე, რომ AI-ს გამოყენებამ შეიძლება ფსიქიკურ ჯანმრთელობას სერიოზული ზიანი მიაყენოს. წლის ბოლოს გავიგეთ, რომ ზოგიერთ შემთხვევაში ეს შეიძლება სიკვდილით და მკვლელობითაც კი დასრულდეს.

იხილეთ: OpenAI-ს მკვლელობისა და თვითმკვლელობის წახალისებისთვის სასამართლოში უჩივიან

გარდა ამ პირდაპირი ზიანისა, AI-მ შეიძლება გარემოს დაზიანებითაც შეგვიქმნას საფრთხე. გასულ წელს გამოქვეყნებული კვლევის მიხედვით, AI-ს მიერ ზოგიერთ შეკითხვაზე პასუხისას შეიძლება იმაზე 50-ჯერ მეტი ნახშირორჟანგი გამოიყოფოდეს, ვიდრე ინფორმაციის სხვაგვარად მოძიებისას. ChatGPT-ს შემქმნელი OpenAI-ს დირექტორმა, სემ ალტმანმაც, გვაცნობა 2025 წელს, რომ ჩატბოტებთან ჩვენი ყოველი სიტყვა — თუნდაც ყოველი თავაზიანობა — შეიძლება, კომპანიებს მილიონობით დოლარი უჯდებოდეთ, რადგან მათ სამუშაოდ უამრავი წყალი და ელექტროენერგიაა საჭირო.

ამ ყველაფრის ფონზე ექსპერტებმა გაგვაფრთხილეს, რომ ხელოვნური ინტელექტის უკონტროლო განვითარება სერიოზული საფრთხეა; იმასაც კი შიშობენ, რომ AI ბირთვულ ომს დაიწყებს.

იხილეთ: ექსპერტები შიშობენ, რომ ხელოვნური ინტელექტი ბირთვულ ომს დაიწყებს

AI სხვა ყველაფერთან ერთად გაწაფული მკვლევარიც არის

ხელოვნური ინტელექტის სისტემების შექმნას ბევრი კვლევა სჭირდება, თუმცა ეს სისტემებიც თავის მხრივ მონაწილეობს მეცნიერების განვითარებაში — თუნდაც იმით, რომ მკვლევრები AI მოდელებს ნაშრომების წერის დროსაც იყენებენ.

დიდი ალბათობით, ერთხელ მაინც წაგიკითხავთ ხელოვნური ინტელექტით (AI) შექმნილი მასალა ისე, რომ ამას ვერც კი მიხვედრილხართ. 2025 წელს კვლევა გამოქვეყნდა, რომლითაც ავტორებმა უამრავ ნაშრომში აღმოაჩინეს AI-ს კვალი.

გარდა ამისა, გასულ წელს ხელოვნური ინტელექტის პოტენციალი კიდევ არაერთი კუთხით დავინახეთ, იქნება ეს: მკვდარი ზღვის გრაგნილებისა თუ რომაული წარწერების გაშიფვრა, ხანძრების პროგნოზირება, ფიზიკის ახალი კანონების გამოვლენა თუ ცხოველების ენის გაგება ან გაადვილება.

საბოლოო ჯამში, 2025 წელს AI-ს შესახებ — მათ შორის ჩვენს ცხოვრებაში მის თანამონაწილეობასა და ამის შედეგებზე — არაერთი კვლევა და საინტერესო შემთხვევა დაგვიგროვდა (ცხადია, ეს სრული ჩამონათვალი არც იყო). გავიგეთ, რომ AI ერთდროულად შეიძლება დაგვეხმაროს და დაგვაზიანოს კიდეც; სიცოცხლე იხსნას ანდა კრიზისი გააღრმაოს; საქმიანობა თუ ფიქრი გაგვიმარტივოს და თან საამისო უნარების შეგვისუსტოს.

ხელოვნური ინტელექტი ზოგისთვის შეიძლება უბრალოდ ინსტრუმენტია, თუმცა რთულია უარვყოთ, რომ იგი აქტიურად მოქმედებს ჩვენს კეთილდღეობაზე, გადაწყვეტილებებსა და ურთიერთობებზე.

იმედი გვაქვს, ეს მიგნებები ერთგვარი საფუძველი იქნება, რათა 2026 წელს AI-ს გააზრებული, პასუხისმგებლობიანი და ჯანსაღი გამოყენება შევძლოთ. NEXT.On.ge-ს გუნდი ამ მისიაში წელსაც თქვენ გვერდით იქნება.

თუ სტატიაში განხილული თემა და ხელოვნური ინტელექტის სფერო შენთვის საინტერესოა, შემოგვიერთდი ჯგუფში, სადაც ვლაპარაკობთ ხელოვნურ ინტელექტზე.

კომენტარები