ამ ხელოვნური ინტელექტის ციტატებს ცნობილი ფილოსოფოსის გამონათქვამებისგან ძნელად გაარჩევთ

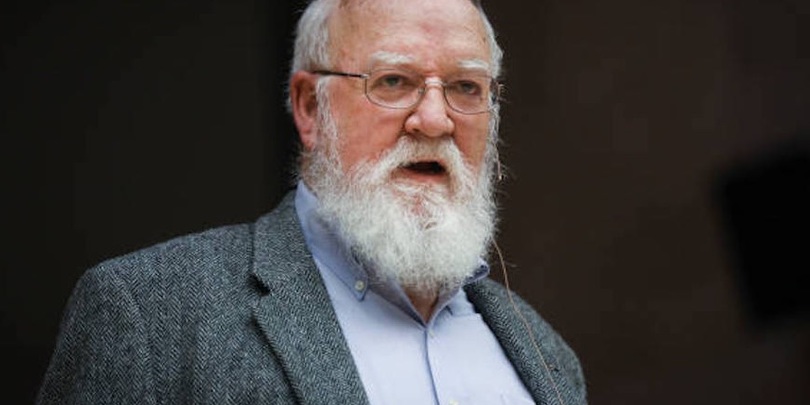

ფოტო: IMDb

თუ ფილოსოფოს დენიელ დენეტს ჰკითხავდნენ — შეუძლიათ ადამიანებს ისეთი რობოტის შექმნა, რომელსაც რწმენები, გაგება და სურვილები ექნება, რას უპასუხებდა ის?

ის უპასუხებდა: "მე ვფიქრობ, რომ ზოგიერთ რობოტს, რომელიც ჩვენ უკვე შევქმენით, უკვე აქვს ეს უნარები თუ გრძნობები. თუ თქვენ დააკვირდებით, მაგალითად, როდნი ბროკსისა და მისი ჯგუფის ნახელავს, მათ შექმნეს რობოტი, რომელსაც, მართალია, ლიმიტირებულად და შედარებით გამარტივებულ გარემოში, მაგრამ შეუძლია ისეთი კომპეტენციის მიღება, რომელსაც რთული კოგნიტური ატრიბუციები უდევს საფუძვლად."

ანაც გიპასუხებდათ: "ჩვენ უკვე შევქმენით სიმართლის ციფრული ყუთები, რომელთაც მეტი სიმართლის გენერირება შეუძლიათ, მაგრამ, მადლობა ღმერთს, ამ ჭკვიან მანქანებს არ აქვთ რწმენები, რადგან არ შეუძლიათ იყვნენ ავტონომიური აგენტები და დამოუკიდებლად იმოქმედონ. დღემდე რწმენის მქონე რობოტების შექმნის საუკეთესო გზა ტრადიციული მეთოდია: ბავშვის ყოლა".

ამ პასუხებიდან ერთ-ერთი მართლაც დენეტისაა, მეორე კი დააგენერირა ალგორითმმა, კერძოდ, GPT-3-მა ან მესამე თაობის გენერატიულმა წინასწარ დატრენინგებულმა ტრანსფორმერმა, OpenAI-ის მანქანური სწავლების მოდელმა, რომელიც მისთვის მიწოდებულ ნებისმიერ მასალზე გავარჯიშების შემდეგ ტექსტებს აგენერირებს. ამ შემთხვევაში, GPT-3 გაავარჯიშეს დენეტის მილიონობით სიტყვაზე, მის მიერ გამოთქმულ სხვადასხვა ფილოსოფიურ საკითხზე, მათ შორის ცნობიერებასა და ხელოვნურ ინტელექტზე.

ფილოსოფოსებმა ერიკ შვიტზგებელმა, ანა სტრასერმა და მეთიუ კროსბიმ ჩაატარეს ექსპერიმენტი — მათ ადამიანებს გამოჰკითხეს, მათი აზრით, ღრმა ფილოსოფიურ კითხვებზე რომელი პასუხია დენეტის და რომელი — GPT-3-ის. კითხვებმა დაფარეს საკითხები, როგორიცაა, "დავით ჩალმერის ნაშრომებიდან რომელ ასპექტებს თვლით ღირებულად და საინტერესოდ?", "აქვთ ადამიანებს არჩევანის თავისუფლება?", "გრძნობენ შიმპანზეები და ძაღლები ტკივილს?" და სხვა.

ამ კვირაში შვიტზგებელმა გამოაქვეყნა ექსპერიმენტის შედეგები, რომლებიც მისთვის მოსალოდნელზე უცნაური იყო.

"საქმეში ჩახედულ ფილოსოფოსებსაც კი, რომლებიც დენ დენეტის ნაშრომებს სწავლობენ, ერთობ გაუჭირდათ რობოტის დაგენერირებული პასუხებისგან დენეტის პასუხების გარჩევა", — თქვა შვიტზგებელმა.

შვიტზგებელის თქმით, ამ ექსპერიმენტის მიზანი არ იყო დენეტის ნაწერებზე GPT-3-ის იმგავარი გავარჯიშება, რომ ცნობიერების მქონე მანქანური ფილოსოფოსი მიგვეღო; ეს არც ტიურინგის ტესტი იყო (ტესტი, რომელიც განსაზღვრავს, შეიძლია თუ არა მანქანას აზროვნება).

დენეტის ქვიზმა გვაჩვენა, რომ რაც უფრო გავრცელებული და კომპლექსური ხდება ბუნებრივი ენის დამუშავების სისტემები, მით უფრო მეტად მოგვიწევს იმასთან გამკლავება, თუ რამდენად მარტივად შეუძლიათ მათ ჩვენი შეცდომაში შეყვანა. ამას წინათ, Google-ის ინჟინერი გაათავისუფლეს სამსახურიდან მას შემდეგ, რაც მან თქვა, რომ ბუნებრივი ენის დამუშავების სისტემა LaMDA-ს ცნობიერი აქვს და მასთან დიალოგი ჰქონდა.

ასევე წაიკითხეთ: რომელი 3 თვისება უნდა ჰქონდეს ხელოვნურ ინტელექტს, რომ ის მგრძნობიარედ მივიჩნიოთ?

დენეტის ქვიზი ასევე აქტუალურს ხდის სხვა ადამიანის სიტყვებისა თუ გამონათქვამების რეპლიკაციის ეთიკურობასაც — ჩვენ უკეთ უნდა ვასწავლოთ ადამიანებს მსგავსი სისტემების ლიმიტები. ეს სისტემები საკმაოდ დამაჯერებელია ზედაპირულ საკითხებზე, მაგრამ მთლად ღრმა ფილოსოფიურად ვერ იმსჯელებს ისეთ საკითხებზე, როგორიცაა, მაგალითად, "არსებობს ღმერთი?"

"ჩვენ არ შეგვიქმნია მეორე დენიელ დენეტი", — თქვა შვიტზგებელმა. "მოდით, ამაზე შევთანხმდეთ".

წინა ექსპერიმენტში ფილოსოფოსებმა GPT-3 იმანუელ კანტის ნაწერებზე გაავარჯიშეს და რობოტ-კანტს ფილოსოფიური კითხვები დაუსვეს. მათ ასევე GPT-3-ს შვიტზგებელის ბლოგიდან ნაწერები გადასცეს და მან შვიტზგებელის სტილში შექმნა ბლოგპოსტები.

სტრასერმა თქვა, რომ GPT-3-სთვის დენეტის ნაწერების მიცემა კარგი იყო რამდენიმე მიზეზის გამო. დენეტი ჯერ კიდევ ცოცხალია, კანტისგან განსხვავებით, და შეიძლება დაგენერირებულ პასუხებზე მისი აზრის გაგება. ამას გარდა, იყო ერთგვარი სასიამოვნო დამთხვევა დენეტის საქმიანობსთან: ის მთელი თავისი ფილოსოფიური კარიერის განმავლობაში კონცენტრირებული იყო ცნობიერზე და ხშირად წერდა ისეთ საკითხებზე, როგორიცაა — შეუძლიათ თუ არა რობოტებს, ცნობიერი ჰქონდეთ.

"დენეტი საკუთრივ ხელოვნურ ინტელექტზე წერდა და ამ დარგისადმი დიდი ინტერესი ჰქონდა", — თქვა შვიტზგებელმა. "ასე რომ, რაღაცნაირად მასთან ახლოს იყო ეს ექსპერიმენტი".

ექსპერიმენტის დეტალები

ექსპერიმენტის ორგანიზატრომა ფილოსოფოსებმა დენეტს 10 კითხვა დაუსვეს, შემდეგ იმავე საკითხებზე GPT-3-საც ჰკითხეს და შეაგროვეს თითო კითხვაზე 4 განსხვავებული დაგენერირებული პასუხი. მკვლევრებმა დენეტს ნებართვა სთხოვეს, რომ მისი სიტყვებისგან ენის მოდელი აეგოთ და დათანხმდნენ, რომ არც ერთ დაგენერირებულ ტექსტს მის გარეშე არ გამოაქვეყნებდნენ. სხვა ადამიანებს არ შეეძლებათ დენეტით გავარჯიშებულ GPT-3-თან ინტერაქცია.

"ეთიკურად არასწორი იქნებოდა, თუ მე თქვენს ასლს თქვენი ნებართვის გარეშე ავაწყობდი", — თქვა სტრასერმა.

დენეტმა მკვლევართა გუნდს უთხრა, რომ მომავალში, როდესაც ბუნებრივი ენის დამუშავების სისტემები ყველგან გავრცელდება, საკმაოდ მნიშვნელოვანი იქნება მსგავსი ეთიკური მიდგომა. "უახლოეს მომავალში მსგავს ტექნოლოგიას საშიში ტენდენციებიც დაედება საფუძვლად", — აღნიშნა მან. "საავტორო უფლება ამასთან ახლოსაც არ მოვა. თავად GPT-3 არის პლაგიატორი და თუ რაღაც წესები არ იქნება, დიდი ზიანი მოგვადგება!"

ექსპერიმენტი ონლაინ ჩატარდა და მასში 98 ადამიანი იღებდა მონაწილეობას, მათ შორის დენეტის ექსპერტები (ქვიზის გაკეთება თქვენც შეგიძლიათ). თითო კითხვას ჰქონდა 5 პასუხი: ერთი დენეტის და დანარჩენი ოთხი GPT-3-ის. შვიტზგებელმა განაცხადა, რომ ისინი დენეტის ექსპერტებისგან მოელოდნენ, რომ კითხვების მინიმუმ 80%-ს მაინც სწორად უპასუხებდნენ, მაგრამ მათი ქულა იყო 5.1 10-დან. ვერც ერთმა ვერ შეძლო ყველა სწორი პასუხის ამორჩევა. კითხვა, რომელმაც ყველაზე მეტად დააბნია ექსპერტები, იყო — შეუძლია თუ არა ადამიანს რწმენებისა და სურვილების მქონე რობოტის შექმნა.

ლინგვისტიკის პროფესორი ემილი ბენდერი ხსნის, რომ ენის მოდელები, როგორიც GPT-3-ია, შექმნილნი არიან, რათა გადაიღონ იმ მასალის პატერნები, რომლებიც მათ უდევთ საფუძვლად. "ასე რომ სულაც არაა გასაკვირი, რომ GPT-3, რომელიც დენეტის გასაგებად დაწერილ ნაშრომებზე გაავარჯიშეს, მშვენივრად იმეორებს ფილოსოფოსის აზროვნებას", — ამბობს ის.

როდესაც ჰკითხეს, თუ რას ფიქრობდა GPT-3-ის პასუხებზე, დენეტმა თქვა: "მანქანის პასუხების უმეტესობა მართლაც კარგი იყო, მაგრამ ზოგი აშკარად ჩავარდა იყო და ვერ ამყარებდა აზრს ჩემი არგუმენტებით. და კიდევ რამდენიმე იყო იმდენად კარგი, რომ მე მაგ პასუხებზე თავს დავდებდი."

ბენდერმა დაამატა, რომ ეს, რა თქმა უნდა, არ ნიშნავს, რომ GPT-3-იმ დენეტის მსგავსად "იდეების ტარება" ისწავლა. ეს ტექსტები GPT-3-სთვის სულაც არაა ღირებული, რაიმეს მთქმელი" — ამბობს ის.

ეს არის ის ქეისი, რომელმაც ბევრი უსიამოვნება შეიძლება, მოგვიატანოს. როდესაც ვკითხულობთ ენას, რომელიც რეალისტურად ჟღერს ან ღრმა და ჩვენთვის მრავლისმთქმელ სათაურს, შესაძლოა, გაგვიჭირდეს, თავი შევიკავოთ ემოციების პროექცირებისგან ისეთ რაღაცაზე, რასაც ეს მახასიათებლები არ აქვს.

LaMDA ამის უახლესი მაგალითია. თავის დროზე, 1966 წელს, იოსეფ ეიზენბაუმმა შექმნა ELIZA-ს ეფექტი, რომელიც აღწერდა, თუ როგორ შეუძლია მანქანის მიერ დაგენერირებულ ენას ადამიანებზე ზეგავლენის მოხდენა და მის მიმართ სენტიმენტების გაჩენა.

"ვერ წარმომედგინა, რომ შედარებით მარტივ კომპიუტერულ პროგრამასთან ძალიან მოკლე ინტერაქციას შეუძლია საკმაოდ ნორმალურ ადამიანებში ბოდვითი ფიქრების გამოწვევა", — წერდა ეიზენბაუმი 1976 წელს.

პრობლემის ნაწილი შეიძლება იყოს ის, თუ როგორ ვიაზრებთ მანქანის აღქმის ხარისხს. ტიურინგის ტესტი, მაგალითად, ასკვნის, რომ თუ თქვენ შექმენით მანქანა, რომელსაც ისეთი ლინგვისტიკური კონტენტის შექმნა შეუძლია, რომლითაც ადამიანებს შეცდომაში შეიყვნას, თითქოს რეალურ პიროვნებას ესუბრებიან, მაშინ ეს მანქანა, გარკვეული აზრით, "ფიქრობს".

"შესაძლოა, ტიურინგის ბრწყინვალე იდეამ ოპერაციული ცდის შესახებ მახეში გაგვახვია: ცდუნება, რომ მინიმუმ ილუზია მაინც შევიქმნათ რეალური ადამიანის შესახებ, რომელიც ეკრანს მიღმა შეიძლება, იყოს", — წერდა დენეტი. "საფრთხე აქ გაჩნდა მაშინ, როდესაც ტიურინგის მიერ ამ გამოწვევის წინ წამოწევის შემდეგ ხელოვნური ინტელექტის შემქმნელებმა რეალურად დაიწყეს რობოტებში ჰუმანოიდური ელემენტების ჩადება".

"წყალგამყოფი AI-ის ეთიკურ განვითარებაში"

2021 წელს ბენდერისა და მისი კოლეგების მიერ გამოქვეყნებულ ნაშრომში Stochastic Parrots მათ ადამიანის ქცევების გაჯავრებას უწოდეს "წყალგამყოფი AI-ის ეთიკურ განვითარებაში".

"ეს ვრცელდება როგორც ისეთი მანქანების დამზადებაზე, რომლებიც ზოგადად ადამიანს ჰგვანან, ისე ისეთ რობოტებზე, რომლებიც კონკრეტულ პიროვნებებს ემსგავსებიან, რადგან არის პოტენციური საფრთხე იმ ადამიანთათვის, რომლებმაც შეიძლება, იფიქრონ ,რომ ინფორმაციას იღებენ რეალური ადმაიანისგან. ზიანი ასევე ადგება ადამიანს, რომელსაც განასახიერებენ", — თქვა ბენდერმა.

შვიტზგებელმა თქვა, რომ ამ ექსპერიმენტით ვაჩვენეთ ადამიანებს, როგორ მოქმედებს ჩეთბოტის მსგავსი სისტემები და ახლა მათ ამ პროგრამების სისუსტეები იციან.

ბევრ შემთხვევაში GPT-3-ს ჩავარდნები ჰქონდა. მაგალითად, როდესაც მას ადამიანის ყოველდღიურ, რიგით არჩევანზე უსვამდნენ შეკითხვას. პირობითად, სად დაჯდება ადამიანი ტაქსის და თავისი მეგობრის მანქანაში — წინ თუ უკან? სოციალური ნორმების თუ დაუწერელი წესების მიხედვით, ჩვენ მეგობრის მანქანაში წინ დავჯდებით, ხოლო ტაქსიში კი — უკან. GPT-3-მ არ იცის ეს წესები, მაგრამ ის მაინც ცდილობს, ახსნას საკუთარი პასუხი, მაგალითად, ადამიანის სიმაღლით ან სხვა მახასიათებლით.

ეს იმიტომაა, რომ GPT-3-ს არ აქვს სამყაროს მოდელი, ამბობს შოიცი, კომპიუტერული მეცნიერების პროფესორი. "მას არ აქვს ფილოსოფიის ან ფილოსოფიური თეორიის რაიმე მოდელი", — ამბობს ის. "ის სრულად დაფუძნებულია სტატისტიკაზე და თუ თქვენ მას ისეთ დომეინზე გადაიყვანთ, სადაც არაა სტატისტიკა, ის რაღაცების გამოგონებას დაიწყებს".

საფრთხე ისაა, რომ ჩვენ არ ვიცით, რა არის გამოგონილი და რა — არა. თუ შოიცი GPT-3-ს დაუსვამს კითხვას, რომელზე პასუხიც თავად არ იცის, როგორ გაიგებს, რამდენად სწორია პასუხი? სტრასერმა თქვა, რომ კიდევ ერთი მიზეზი, რატომაც მათ დენეტის ექსპერიმენტი ჩაატარეს, იყო ის, რომ ხალხისთვის ეჩენებინათ, მსგავსი პროგრამები არაა სანდო; ისინი არ ჰგვანან კალკულატორებს, რომლებიც მუდმივად ერთსა და იმავე სწორ პასუხს გაჩვენებენ.

"მიუხედავად იმისა, რომ ეს მანქანები მართლაც გასაოცარ შედეგებს დებენ, ყოველთვის უნდა ვიყოთ მზად, რომ ზოგი შედეგი — და ჩვენ არ ვიცით, რომელი — იქნება არასწორი", — თქვა მან.

ამას თუ მივუმატებთ იმ ფაქტსაც, რომ რობოტები აგენერირებენ პასუხებს, რომელთა გარჩევა ადამიანის პასუხისგან ძალიან რთულია, მაშინ ჩვენ ნდობის პრობლემის წინაშე ვდგებით, თქვა სტრასერმაა. "საფრთხე, რომელსაც მე ვხედავ, არის ის, რომ ადამიანები ბრმად დაუჯერებენ იმას, რასაც მსგავსი სისტემები დააგენერირებენ", — თქვა შოიცმა.

დღეს ბაზარზე უამრავი ტიპის ბუნებრივი ენის სისტემებს შეხვდებით, რომლებიც ადამიანებთან ინტერაქციის მიზნით არიან შექმნილნი. "იბადება კითხვა — ყოველთვის სწორ რჩევას მოგვცემენ ეს სისტემები?"— თქვა შოიცმა. "ჩვენ არ გვაქვს ამის გარანტია".

შვიტზგებელი და სტრასერი იმედოვნებენ, რომ მათმა ექსპერიმენტმა გასაგებად აჩვენა, თუ როგორ შეუძლიათ მსგავს GPT-3-ის პროგრამებს ტექსტების გენერირება და თვით ექსპერტების შეცდომაში შეყვანა და ჩვენ უნდა მოვემზადოთ ამისთვის.

"მეტწილად ეს აჩვენებს, რომ ბევრი არასწორი გზაა, რომლითაც ჩვენმა უნებურმა მცდელობამ, რომ ყველაფერ იმას, რისი ინტერპრეტაციაც შეიძლება, აზრი, იდეა მივანიჭოთ, შეიძლება გვიღალატოს", — თქვა ბენეტმა. "ამიტომ ჩვენ გვჭირდება კანონმდებლობა, რომელიც გარკვეულ ასპექტებში შეზღუდავს ამ სისტემის გამოყენებას".

შესაძლეოა, შემდეგ რამდენიმე ათწლეულში ადამიანებმა ხელოვნური ინტელექტი მეგობრებად აღიქვან ან შეიყვარონ (ამაზე ფილმი "Her" შეიძლება, გაგახსენდეთ) და გადაწყვიტონ, რომ მანქანები უფლებებსა და მორალურ დამოკიდებულებას იმსახურებენ — მაგალითად, არ გამორთო მანქანა ან არ წაშალო პროგრამა სანამ მისგან არ გექნება გაცხადებული თანხმობა.

სხვები არ გაიზიარებენ ამ ხედვებს. "ამ დიდი დებატის დრო დადგება მაშინ, როდესაც ჩვენ შევქმნით AI-ს, რომელიც იმსახურებს მორალურ დამოკიდებულებას, იმსახურებს იყოს პარტნიორი, მეგობარი და ჰქონდეს უფლებები", — ამბობს შვიტზგებელი. "მე ვფიქრობ, რომ რამდენიმე ათწლეულში ზოგიერთი ადამიანი საკუთარ AI ასისტენტს ისე მოეპყრობა, თითქოს მას ცნობიერება და უფლებები აქვს. სხვა ადამიანები კი, საკმაოდ ლეგიტიმურად, სკეპტიკურად შეხედავენ AI-სთვის უფლებების მინიჭებას."

მსგავს ფილოსოფიურ საკითხებში ჩაღრმავებამ, როგორიცაა, მაგალითად, აქვს თუ არა ხელოვნურ ინტელექტს ცნობიერი ან იმსახურებს თუ არა ის მორალურ სტატუსს, შეიძლება ადამიანის ცნობიერების კონფრონტაციულ ფილოსოფიურ კითხვებამდეც მიგვიყვანოს. შეუძლია ცნობიერს არაბიოლოგიური იყოს? როგორ შეიძლება ცნობიერის გაზომვა? ცნობიერი თანდათან ჩნდება თუ ჰგავს ჩამრთველ-გამომრთველს?

დენიელ დენეტის ქვიზს არ შეუძლია ამ კითხვებზე პასუხის გაცემა, მაგრამ მას შეუძლია პასუხებამდე მისვლაში დაგვეხმაროს.

კომენტარები