AI და პოლიტიკა — ინტერვიუ გაეროს AI-ისა და რობოტიკის ცენტრის ხელმძღვანელ ირაკლი ბერიძესთან

ირაკლი ბერიძე ქართველი საერთაშორისო მოღვაწეა, ინოვაციური ტექნოლოგიების, უსაფრთხოების, და საერთაშორისო პოლიტიკის დარგში, რომელიც ამჟამად გაეროში მუშაობს და UNICRI-ში (United Nations Interregional Crime and Justice Research Institute) ხელოვნური ინტელექტის და რობოტიკის ცენტრს ხელმძღვანელობს, რომელიც 2017 წელს თვითონვე დააფუძნა. 2013-2015 წლებში ბერიძე ქიმიურ, ბიოლოგიურ და ბრთვული გაეროში იარაღების რისკების შემცირებას ხელძღვანელობდა. 2013 წელს ის OPCW-ისთვის ნობელის პრემიის მიმღები პირი იყო.

2014 წელს, ამ ორგანიზაციის ზედამხედველობით, სირიამ თავისი ქიმიური იარაღის მარაგის 97% გაანადგურა, მას შემდეგ, რაც 2013 წელს ქვეყანამ ის ადამიანების წინააღმდეგ გამოიყენა, რასაც იმდენად სერიოზული გამოხმაურება მოჰყვა, რომ აშშ და საფრანგეთი სირიაში პირდაპირ სამხედრო ინტერვენციას განიხილავდნენ. საბედნიეროდ, ეს არ მოხდა, რადგან სირია თანამშრომლობას დათანხმდა და ქიმიური იარაღის მარაგების მოსპობის ზედამხედველობის პასუხისმგებლობა გაერომ აიღო.

როცა ადამიანი, რომელიც ქიმიური იარაღის გამოუყენებლობაზე მუშაობდა, აფუძნებს ცენტრს, რომელიც ხელოვნური ინტელექტის და რობოტიკის პოტენციურ საფრთხეებს იკვლევს, ეს გლობალური უშიშროების ძალიან მნიშვნელოვანი საკითხად შეგვიძლია მივიჩნიოთ.

თავისუფალ უნივერსიტეტში გამართულ ლექციაში, ირაკლი ბერიძე ამბობს, რომ გაერო ძალიან დიდი ორგანიზაციაა და როცა ამხელა ორგანიზაცია "ხვდება", რომ ხელოვნური ინტელექტის არაკეთილსინდისიერი გამოყენება შეიძლება პრობლემა იყოს, ე.ი. საქმე სერიოზულადაა. მეორე მხრივ AI ტექნოლოგია კრიმინალურ აქტივობასთან და ტერორიზმთან ბრძოლაში შესაძლოა ძალიან მნიშვნელოვანი ხელსაწყო აღმოჩნდეს.

ავტომატიზებული საომარი მოქმედებები

ფოტო: Public Domain

სამხედრო დრონების გამოყენება აშშ-ის ანტიტერორისტული კამპანიის მნიშვნელოვანი ნაწილია. დრონების გამოყენება მთავრობას საშუალებას აძლევს, რომ ჯარისკაცებმა სიცოცხლე არ გარისკონ და "მშვიდობისმყოფელი" მისიები რობოტებმა შეასრულონ.

თუმცა, 2015 წელს The Intercept-ის მიერ მოპოვებული პენტაგონის გასაიდუმლოებული დოკუმენტების მიხედვით გაირკვა, რომ დრონების თავდასხმისას, დაღუპულთა 90% სამიზნეს არ წარმოადგენდა. დაღუპულთა უმეტესობა "არამებრძოლი" იყო. გაერთიანებული სამეფოს Amnesty International-მა აჩვენა, რომ ამ ოპერაციებს ხელს ბრიტანეთიც უწყობდა.

სკანდალურმა ინფორმაციამ სამხედრო ინტერვენციებში დრონების გამოყენების ეთიკურობა/არაეთიკურობის საკითხი წინ კიდევ ერთხელ წამოწია. ტექნოლოგიის განვითარებასთან ერთად გაჩნდა შიში, რომ ქვეყნებმა საომარ მოქმედებებში შეიძლება სრულიად ავტონომიური სისტემები გამოიყენონ. დრონებს, საბოლოო ჯამში, მაინც ადამიანები მართავენ და ადამიანის მოკვლის გადაწყვეტილებას ადამიანები იღებენ. ეთიკურია თუ არა, რომ რობოტმა თავისით გადაწყვიტოს ვის მოკლავს?

"პირველ რიგში აბსოლუტურად არაეთიკურია სრულად ავტომატიზებული ტექნოლოგიის გამოყენება სამხედრო მოქმედებებში", — ამბობს ბერიძე. "ერთი მხრივ არის ვარაუდი, რომ ამით შემცირდეს ჯარისკაცების საომარ მოქმედებებში ჩართვა. მეორე მხრივ, ამ იარაღების მსხვერპლი უამრავი უდანაშაულო არის, იქნება და შეიძლება იყოს. ამასთანავე, ომში წასვლის ბარიერი ძალიან დაბლა იწევა, რადგან თუ ქვეყანა ტექნიკას იყენებს ომისთვის და ადამიანურ რესურსს არ ხარჯავს, შეიძლება ბევრად მარტივად გადაწყდეს საომარი მოქმედებების დაწყება".

ბერიძე ამბობს, რომ სახელმწიფოები ზემოხსენებულ პოზიციას იზიარებენ და ჯერჯერობით, არც ერთი ქვეყანა სრულად ავტომატიზებულ სამხედრო ხელსაწყოებზე დეკლარირებულად არ მუშაობს. ანუ, რობოტ ჯარისკაცებს, რომლებიც გადაწყვეტილებებს თავისით იღებენ, ახლო მომავალში, სავარაუდოდ, ვერ ვიხილავთ. ნაწილობრივ იმიტომ, რომ ჯერ სათანადოდ დახვეწილი ტექნოლოგია არც არსებობს და არც მთავარია არსებობს ნება, რომ საომარ მოქმედებებზე პასუხისმგებლობა მთავრობებმა თავიანთ თავზე აიღონ.

თუმცა, თანამედროვე ტექნოლოგიების გამოყენება სხვა ტიპის ომში უკვე დაწყებულია და სერიოზული პრობლემაა.

ინფორმაციული ომი და ტერორიზმი

ბოლო რამდენიმე წელი ქაოტურობით გამოირჩევა. აშშ-ში ყველაზე შესამჩნევი რადიკალური მემარჯვენე (far-right) ტერორიზმია, რომელიც მეტწილად, სოციალურ ქსელებზე გავრცელებული შეთქმულების თეორიებითაა შთაგონებული. იქნება ეს PizzaGate თუ QAnon. ექსპერტები ამბობენ, რომ სოციალური მედია მსგავსი ძალადობრივი ნარატივების და დეზინფორმაციის გავრცელებაში დიდ როლს თამაშობს. ეს არის მოსაზრება, რომელიც კარგადაა გამოკვეთილი დოკუმენტურ ფილმში Social Dilemma.

დიდი სოციალური მედიების Facebook-ის, YouTube-ის და Twitter-ის დეზინფორმაციის გავრცელების შეზღუდვის მცდელობები ხშირად უნაყოფოა.

ცოტა ხნის წინ Unicri-მ გამოაქვეყნა ანგარიში, რომელიც კორონავირუსთან დაკავშირებულ დეზინფორმაციას და მის მიღმა მდგომ "არასამთავრობო" ჯგუფებს მიმოიხილავს. დოკუმენტში ვრცლადაა განხილული შეთქმულების თეორიებით შთაგონებული ტერორიზმი, რომლის ნათელი ილუსტრაციაც ტიმოთი ვილსონის შემთხვევაა.

ტიმოთი ვილსონი FBI-იმ 2020 წლის მარტში მოკლა, რადგან ის კანზასში იმ საავადმყოფოს აფეთქებას გეგმავდა, სადაც COVID-19-ის მქონე პაციენტები იმყოფებოდნენ. ვილსონი Telegram-ის სხვადასხვა არხებში აქტიურობდა და თავის ტერორისტულ გეგმას ნეონაცისტებთან ვრცლად განიხილავდა. არსებობს ორგანიზაციები, რომლებიც ანტისემიტური პროგანდის ნიადაგზე, სხვადასხვა რადიკალებს კორონავირუსით ინფიცირების შემთხვევაში სინაგოგებში წასვლას და "ებრაელებზე დახველებისკენ" მოუწოდებენ.

Unicri-ის დოკუმენტში აღნიშნულია, რომ 2020 აპრილისთვის, სოციალური ქსელების (Facebook და Twitter) აქტიური მომხმარებლების 37%-მა კორონავირუსის შესახებ გავრცელებული დეზინფორმაცია არაერთხელ იხილა. გავრცელებული დეზინფორმაციის 59% არსებული ინფორმაციის განგებ დამახინჯება ან კონტექსტიდან ამოღებაა, 38% კი მთლიანად გაყალბებულია.

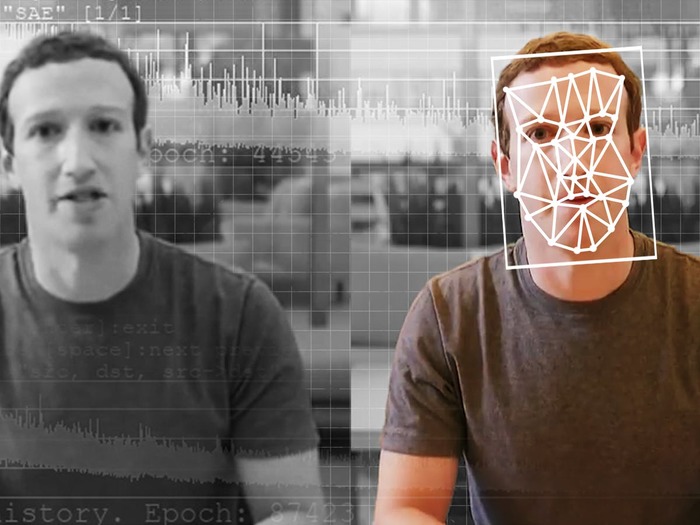

ბერიძე ამბობს, რომ დეზინფორმაციის გავრცელებაში Deepfake ვიდეოები და ხმოვანი ჩანაწერები შეიძლება მნიშვნელოვანი ხელსაწყო გახდეს. არსებობს უამრავი Open Source და კომერციული პროექტი, რომლის დახმარებითაც Deepfake-ის გაკეთება ყველას შეუძლია. საბედნიეროდ, ეს ტექნოლოგია ჯერ საკმარისად დახვეწილი არაა, რომ აბსოლუტურად დამაჯერებელი Deepfake-ების გაკეთება ყველამ შეძლოს, თუმცა, ბერიძის თქმით დროთა განმავლობაში ეს ტექნოლოგია უფრო და უფრო ხელმისაწვდომი გახდება.

Deepfake-ებზე ხშირად, ყალბი ინფორმაცია CheapFake-ებით ვრცელდება. ანუ, უბრალოდ დარედაქტირებული ვიდეოებით ან ხმოვანი მესიჯებით. 2020 წლის 6 თებერვალს ასეთი ყალბი ვიდეო აშშ-ის მაშინდელმა პრეზიდენტმა დონალდ ტრამპმა გააზიარა, სადაც ნენსი პელოსმა, ტრამპის საუბრის დროს, თავისი მოხსენების ფურცელი დახია, როცა სინამდვილეში მან ეს ტრამპის გამოსვლის დასრულების შემდეგ გააკეთა, რაც ერთგვარი საპროტესტო ჟესტი იყო, თუმცა ვიდეო სხვა შთაბეჭდილებას ტოვებს.

პოლიტიკური კომენტატორები ხშირად მიანიშნებენ, რომ "ინფორმაციულ ომს" არაკეთილსინდისიერი და ექსტრემისტული დაჯგუფებები იგებენ, თუმცა ირაკლი ბერიძე ამ სენტიმენტს არ იზიარებს:

"ჩვენი ცენტრი, იმის გარდა, რომ ანალიზს აკეთებს, როგორ შეიძლება ეს ტექნოლოგია გამოყენებული იყოს "ცუდების" მხრიდან, ასევე ჩვენი კვლევის მეორე ნაწილია, როგორ შეიძლება ეს ტექნოლოგია გამოყენებული იყოს სამართალდამცავი ორგანოების მიერ. 2017 წლიდან შევქმენით პლატფორმა ჩვენ ცენტრსა და ინტერპოლს შორის და ყოველწლიურად ვაწყობთ გლობალურ შეხვედრებს, როგორიცაა AI for Law Enforcement და ურთიერთობა გვაქვს სამართალდამცავ ორგანოებთან, რომლებიც AI ხელსაწყოებს იყენებენ".

თუმცა, AI-ის და თანამედროვე ტექნოლოგიების მთავრობების მიერ გამოყენება ბოლო დროს ასევე პრობლემური საკითხია, განსაკუთრებით ისეთ ქვეყნებში, როგორიცაა ჩინეთი, სადაც ახალი ტექნოლოგიები ადამიანების თავისუფლების შეზღუდვის და პრივატული ინფორმაციის არაეთიკური მოპოვებისთვის გამოიყენება. ადამიანის უფლებების უხეში დარღვევები, ხშირად კონტრტერორისტული კამპანიის გასამართლებლად გამოიყენება.

ბუნდოვანი ზღვრები და ადამიანის უფლებები

ფოტო: Kevin Hong

Surveillance State შედარებით ახალი ტერმინია, რომლის აქტიური გამოყენება თავიდან აშშ-ში მას შემდეგ დაიწყო, რაც ედუარდ სნოუდენმა ათასობით დოკუმენტი გამოააშკარავა, რომლის მიხედვითაც აღმოჩნდა, რომ აშშ-ის NSA, ავსტრალიის და ბრიტანეთის მსგავსი სააგენტოები, ადამიანების პრივატული ინფორმაციის უფლებებს არღვევდნენ ან ხშირად მოქალაქეების ნებართვის გარეშე ოპერირებდნენ.

ირაკლი ბერიძე აღნიშნავს, რომ AI მოდელების და ტექნოლოგიის განვითარება სახელმწიფოებს უპრეცედენტო ძალაუფლებას აძლევს. ამის ნათელი ილუსტრაცია ჩინეთია, სადაც 2014 წლიდან სოციალური კრედიტების სისტემა ამოქმედდა, რომელიც მასშტაბურ სახელმწიფო ზედამხედველობას და ჩინეთის "ამომცნობ" სისტემას ეყრდნობა.

მარტივად რომ ითქვას, ჩინეთში მოქმედებს დახვეწილი კამერების უზარმაზარი ქსელი, რომელიც ადამიანებს "ამოიცნობს" და პოულობს. სისტემა, ძირითადად, კრიმინალური აქტივობის წინააღმდეგ არის მიმართული.

ქალაქ ვუჰუში კამერების სისტემამ მკვლელი ამოიცნო, რომელიც ქუჩაში საჭმელს ყიდულობდა. ქინგდაოში, ამომცნობი სისტემის დახმარებით, ჩინეთის პოლიციამ რამდენიმე ათეული კრიმინალი დააკავა და ა.შ. მილიონობით კამერა და მძლავრი ამომცნობი სისტემა კრიმინალურ აქტივობასთან საბრძოლველად შეიძლება ეფექტიანია, მაგრამ ის ხშირად პოლიტიკური დისიდენტების დასაჭერად და ავტორიტარული რეჟიმის შესანარჩუნებლად გამოიყენება.

სოციალური კრედიტების სისტემა ადამიანების პროფილებს ადგენს და მათ ქცევას აფასებს. ვინმე თუ მუსიკას ხმამაღლა უსმენს, წითელზე გადადის და ა.შ, "სოციალურ ქულებს" იკლებს. ვინმე თუ დასავლურ მედიას მოიხმარს, უარყოფს ჩინეთის კომუნისტური პარტიის სწავლებებს, შეიძლება "ხელახალი განათლების" ბანაკებში გაუშვან და ა.შ

"ერთ-ერთი გლობალური პრობლემაა ბალანსი უსაფრთხოებასა და პირადი ინფორმაციის დაცვას შორის. სახელმწიფოებს აქვთ საშუალება გამოიყენონ ასეთი ტექნოლოგიები "ცუდი" მიზნებისთვის ან საერთოდ, არალეგალური მიზნებისთვის, თუმცა იყენებენ თუ არა ჩემი — გაეროს ცენტრის ხელმძღვანელის გასარჩევი არაა", — ამბობს ირაკლი.

UNICRI აქვეყნებს დოკუმენტებს, რომლებიც სახელმწიფოებს და სამართალდამცავებს თანამედროვე ტექნოლოგიების ეთიკური მიზნებისთვის გამოყენებაში დაეხმარება. "ასეთი გლობალური ხელსაწყოები [იგულისხმება გაიდლაინები] შექმნის პროცესშია, დაინერგება სხვადასხვა ქვეყნებში, რომლებიც პირდაპირ მიუთითებს როგორ და რა ფორმით, რა წითელი ხაზების არგადაკვეთით შეიძლება ამ ტექნოლოგიების გამოყენება", — ამბობს ირაკლი ბერიძე. მისი თქმით, ქვეყნების უმეტესობა თანამედროვე ტექნოლოგიების ეთიკური გამოყენებითაა დაინტერესებული. "სხვადასხვა ქვეყნები ქმნიან თავის ეროვნულ რეგულაციებს, რომელიც პირად მონაცემებს და ადამიანის პირად ცხოვრებას იცავს. მეტნაკლებად, ქვეყნებში ასეთი რეგულაციები უკვე ინერგება".

ბერიძის თქმით ბევრგან ხელოვნური ინტელექტის რეგულაციები ინერგება, რაც "ძალიან მნიშვნელოვანია".

უშიშროება და ოპტიმიზმის მიზეზები

ფოტო: Foreign Affairs

ხელოვნურ ინტელექტის გარშემო შექმნილი "აჟიოტაჟის" ფონზე, გაეროს ცენტრის ხელმძღვანელისგან დამაიმედებელი კომენტარების მოსმენა მნიშვნელოვანია. ნაწილობრივ იმიტომ, რომ ხელოვნური ინტელექტი, ბოლო დროს, ბუნდოვანი ტერმინი გახდა, რომელიც ხშირად გულისხმობს ყველაფერს, დაწყებული მანქანური დასწავლიდან, სუპერინტელექტით დამთავრებული, რომელიც, შესაძლოა, სამყაროს თავისი ელექტრონული საცეცების ქვეშ მოიქცევს.

რეალობა ბევრად უფრო მოსაწყენია. ხელოვნური ინტელექტი, ამ ეტაპზე, ძალიან შეზღუდულია და შორსაა "ზოგადი ინტელექტისგან", რომლის აპოკალიფტურ აღზევებასაც ბევრი მოელის. ბერიძე ამბობს, რომ ხელოვნური ინტელექტის მოდელები სამართალდამცავებისთვის ძალიან მნიშვნელოვანია და როგორც მინიმუმ ამ მომენტში, მისი ეფექტიანი გამოყენება უზარმაზარ რესურსს უკავშირდება, რომელიც ძირითადად სწორი მიზნებისთვის იხარჯება.

თუმცა, საფრთხე მზარდია. ჩვენი შიშები, რომ ხელოვნური ინტელექტის გამოყენებით ტერორისტები და რადიკალური დაჯგუფებები თავიანთ აქტივობას უფრო სრულყოფენ, შეიძლება მალე გამართლდეს და UNICRI, ისევე როგორც გაეროს სხვა განშტოებები და სახელმწიფოები, ამის პრევენციისთვის აქტიურად მუშაობენ.

თუმცა ის, რომ ხელოვნური ინტელექტის მოდელების გამოყენება კიბერუსაფრთხოებაში და ზოგადად, სამართლებლივ სისტემაში დიდ ადამიანურ და ფინანსურ რესურსს უკავშირდება, სიტუაციას ართულებს. განვითარებადი სახელმწიფოები ხელოვნური ინტელექტის უსაფრთხოების ნორმების შემუშავებაში სწორედ ამიტომ, მეტნაკლებად ჩამორჩებიან.

ბერიძის თქმით, ხელოვნური ინტელექტის პასუხისმგებლიანი გამოყენება დიდი კორპორაციების (Google-ის, Amazon-ის და ა.შ) მოვალეობაცაა. ახლად აღმოცენებული ტექნოლოგიის გამოყენებაში ეთიკური ხაზების გავლება მნიშვნელოვანია, შესაბამისად UNICRI უმნიშვნელოვანეს როლს თამაშობს, რათა ეს ხაზები სწორად იქნას გავლებული.

ინტერვიუს ბოლოს ბერიძე ამბობს, რომ უშიშროების საკითხით უნივერსიტეტის პირველი კურსიდან ინტერესდება და ახლა ამ სფეროში მუშაობა განსაკუთრებით საინტერესოა, თუ გავითვალისწინებთ გამოწვევებს, რომლის წინაშეც მსოფლიო აღმოჩნდა.

ირაკლი ბერიძე ტექნოლოგიების და საერთაშორისო ურთიერთობის საკითხებზე აქტიურად 1999 წლიდან მუშაობს. "მაშინ ფინეთში ნოკიას ბაზაზე ვსწავლობდი, რადგან ფინეთი იყო ამ მხრივ ყველაზე განვითრებული [იგულისხმება ე.წ. GSM ტექნოლოგიები]".

ირაკლი ბერიძე, ცხადია, ერთადერთი ადამიანი არაა, ვინც ხელოვნური ინტელექტის და რობოტიკის განვითარების საერთაშორისო ურთიერთობებზე და სამართალზე არსებულ გავლენას სწავლობს. ფაქტი, რომ გაერთიანებული ერები ამ საკითხების შესწავლაში დიდ რესურსს დებს და ეს ინფორმაცია საჯაროდაა ხელმისაწვდომი, ძალიან დამაიმედებელია. მით უფრო, ისეთ ეპოქაში სადაც, ტექნოლოგიების დახმარებით, ზღვარი სიმართლესა და ფიქციას შორის თანდათანობით იშლება.

კომენტარები